🎥🎞️📝:「編碼偏見」| AI來自數據,而數據來自歷史

「編碼偏見」(Coded Bias)是2020年的Netflix紀錄片,紀錄片講述工程師所一手打造的程式在不同的人種身上竟然產生了人為才有的偏見,甚至更擴大至求職、居住、購物......生活的各種層面。近年來Netflix製做了不少關於科技對於社會、民主、人權、個資的影響(如「智能社會:進退兩難」(The Social Dilemma)、「個資風暴:劍橋分析事件」(The Great Hack)…)

這一部紀錄片主要聚在數據上,當我們需要透過大量數據訓練人工智慧時,紀錄片的受訪人同時也是《大數據的傲慢與偏見》(Weapons of Math Destruction)的作者凱西.歐尼爾(Cathy O’Neil)提出了對於所有程式設計師的質疑:

- 我們用了甚麼數據訓練機器?

- 這些數據如何取得?

- 更重要的是,是誰決定要用這些數據的?

不敏感的人工智慧?

故事始於麻省理工的研究人員喬伊(Joy Buolamwini)想要打一面能夠識別人臉的鏡子,但是喬伊不論怎麼測試都無法辨識她的臉,奇怪的是喬伊的白人朋友站到鏡子前時,機器一下子就識別出來了;橋伊試了許久,最後當她戴了一個純白面具時,鏡子上終於捕捉到了喬伊的面部資料。

活生生的人臉竟然比不上一個冰冷的面具?

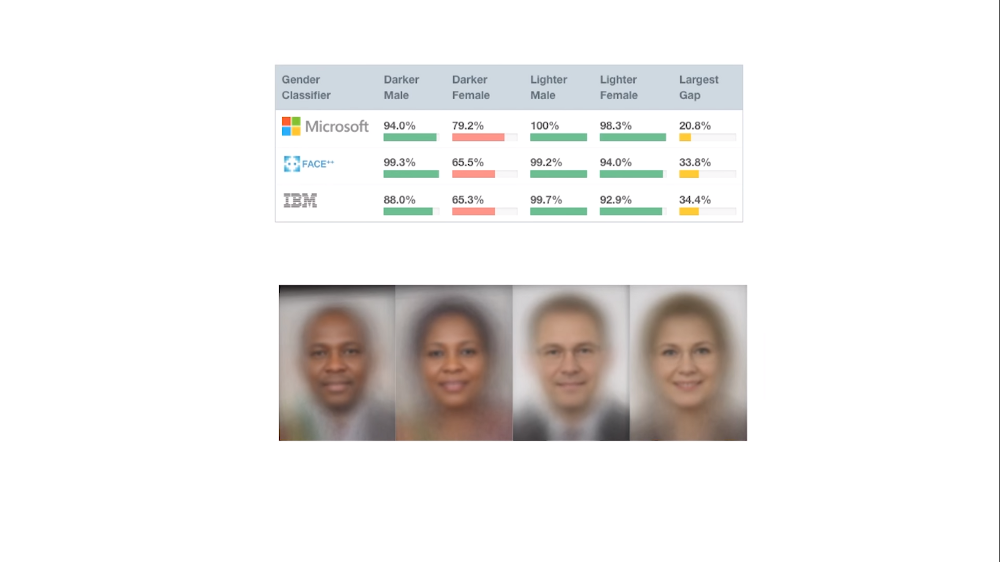

喬伊開啟了研究(Gender Shades),探討這背後出了甚麼問題,竟然發現程式背後隱藏對於有色人種的偏誤;男人的識別度比女人高,淺色皮膚識別度比深色皮膚高。喬伊擴大了照片參數,以至少1200張的照片來進行測試,在膚色分級為VI(實驗最深的膚色分類)的情況下錯誤率甚至高達近乎五成的 46.8%;在這樣如此之高的錯誤率下,幾乎可以說是用擲硬幣的方式在識別人臉。而這就是紀錄片要工程師甚至大眾去思考的,如果我們無差別地餵給機器數據,那麼偏見從何而來?

人臉識別(face recognition / facial-recognition)是近年在科技與人權之間爭議最多的一個話題,這項技術應該要用在哪、可以深入到甚麼層面以及人民是否能夠拒絕科技執法的人臉資料採樣。讓我們來設想一個實驗

如果今天我想要開發一個人臉識別的機器,而我希望只篩選出富豪就好,那麼你會投入甚麼樣的數據給機器呢?

如果你的揀選條件只有男性、西裝、油頭、白人;那麼,你便是落入了編碼的偏見。當給定一個中立主題(富豪,關於這點可能有人會提中國的面相學,暫且先不討論面相學對於福相的分析),我們所給予的數據乃是基於整個歷史文化脈絡下對於富豪的符號印象;數據是中立的,而數據也一直存在於生活中,但是被揀選、分類的數據將會變成資訊,我們主動賦予數據意義。

透過這個思想實驗能讓我們去思考的是,這些印象是如何形成的?我們用甚麼樣的方式瞭這個世界,而世界也會以同樣的方式回應我們。如果能夠用各種角度去參透同一個概念,那麼我們就不會輕易落入世界就是這樣的現成偏誤;倘若程式開發人員不曾想過這些問題,那我們便是將這樣的刻板印象有意無意地流傳下去。

事實上,2016年麻省理工媒體實驗室開發出了一套人工智慧能夠「情感計算」(Affection Computing),而這套人工智慧能夠依照觀測到的人類表情數據解讀出當下受試者的情緒反應;精準度甚至連平時難以注意到的微表情(micro expression)都能監測到,而這些微表情往往是人們容易忽略的。這套人工智慧能夠在人類無法識別自己的面部肌肉微動下,透過內部的數據分析,依舊能得出當前使用者的面部情緒反應,等於比你自己還要了解自己。

科技一再地證明它們的能力早已超越人類,精確度已經不是問題;真正的問題在於,有沒有足夠的數據可以訓練機器?而這些數據是不偏倚任何一方,各種族群、人種的面部資訊都齊全的狀況下,人工智慧的確有辦法辨識相應的結果。

真正有偏見的不是機器,而是人。

喬伊在麻省理工媒體實驗室所做的Gender Shades研究案

https://news.mit.edu/2018/study-finds-gender-skin-type-bias-artificial-intelligence-systems-0212

.

英國反政府監控組織「老大哥監視計畫」(BIG BROTHER WATCH)

https://bigbrotherwatch.org.uk/about/

.

喜欢我的作品吗?别忘了给予支持与赞赏,让我知道在创作的路上有你陪伴,一起延续这份热忱!

- 来自作者

- 相关推荐